Meta lance Llama 4, de nouveaux modèles pour dominer le marché de l’IA

Meta propose quatre modèles distincts, chacun doté de caractéristiques techniques avancées. Le modèle Llama 4 Scout, conçu pour fonctionner sur un seul processeur GPU, est le plus rapide parmi les petits modèles. Il intègre 17 milliards de paramètres et 16 experts, optimisant ainsi les réponses en fonction de la nature des requêtes.

Le modèle Llama 4 Maverick partage la même capacité de paramètres, mais l’élargit avec 128 experts, permettant une activation sélective des paramètres pour réduire les coûts et la latence.

Le modèle Llama 4 Behemoth, avec plus de 2 trillions de paramètres, représente le système le plus vaste actuellement disponible, offrant un potentiel d’apprentissage et d’inférence avancé.

Enfin, le modèle Llama 4 Reasoning reste en partie mystérieux, Meta n’ayant pas encore divulgué tous les détails.

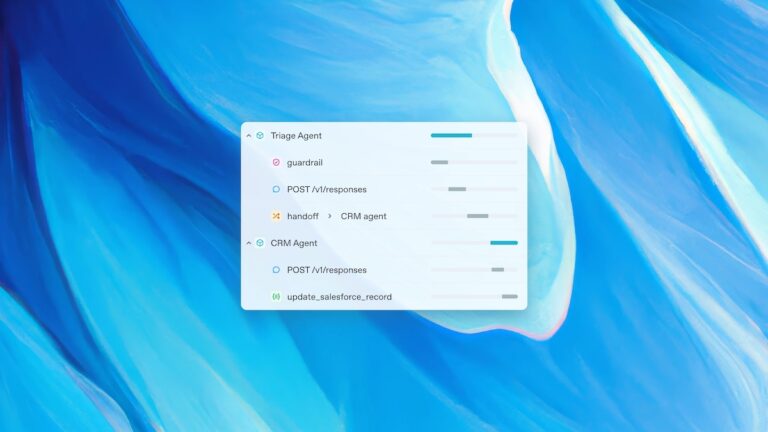

Ces modèles visent à améliorer la logique systématique à travers un vaste ensemble de « paramètres » conçus pour enrichir le processus de raisonnement systématique.

Plus le nombre de paramètres est élevé, plus la capacité analytique du modèle est grande, car il peut explorer un plus grand nombre d’aspects d’une requête et y répondre de manière contextualisée.

Le nombre impressionnant de paramètres de Llama 4 représente plus du double de ce que les versions précédentes de Meta proposaient, ce qui illustre l’évolution progressive de la complexité et de la précision des modèles de Meta.

L’introduction des « experts » dans Llama 4 est une innovation majeure. Elle améliore l’efficacité en déterminant quels paramètres doivent être activés pour chaque requête, ce qui réduit le temps de calcul sans compromettre la précision.

Avec environ 350 000 puces Nvidia H100 alimentant ses projets d’IA, Meta devance ses concurrents comme OpenAI et xAI, qui possèdent chacun environ 200 000 puces. Cette supériorité matérielle se traduit par une habileté de calcul considérable, positionnant Meta comme leader dans le créneau des performances globales d’IA.

Bien que certains remettent en question l’exactitude des tests de Meta et les critères de comparaison choisis, ces modèles semblent globalement offrir des résultats améliorés. L’open source de ces modèles par Meta permet aux développeurs tiers de s’appuyer sur cette technologie pour créer de nouvelles applications d’IA.

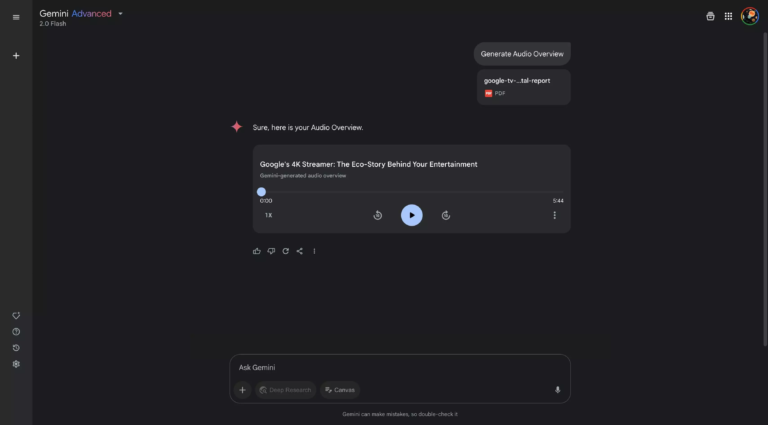

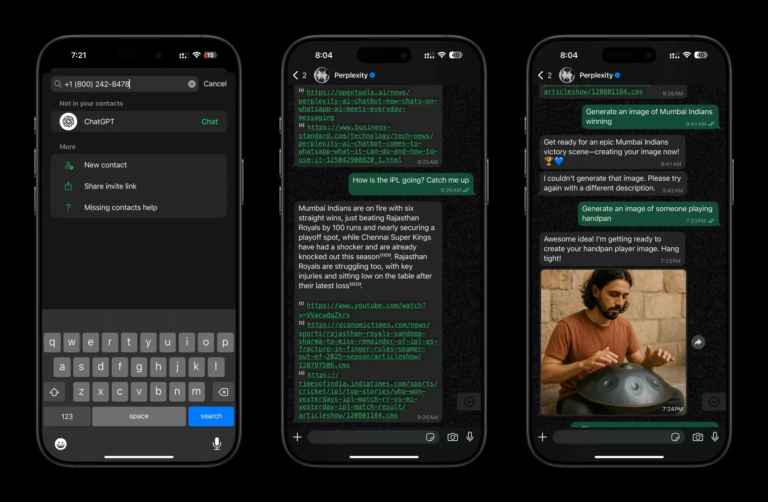

L’intégration des modèles Llama 4 dans les produits Meta améliorera des services tels que le chatbot dans Facebook, WhatsApp, Instagram, et Messenger, tout en optimisant les systèmes de ciblage publicitaire et d’algorithmes.

Pour les utilisateurs, l’avantage principal résidera dans des performances améliorées des fonctionnalités d’IA de Meta, avec des réponses plus précises, des images mieux générées, et des publicités plus pertinentes.

Meta prévoit de déployer ces innovations dans les semaines à venir, renforçant ainsi son rôle central dans le développement de l’intelligence artificielle.

📌 Source(s) et inspiration(s) :

Social Media Today – Meta launches Llama 4 Models, driving improved AI performance

En Bref

- Meta lance ses nouveaux modèles d’IA Llama 4, surpassant la concurrence.

- Quatre modèles distincts avec des paramètres allant jusqu’à 2 trillions sont proposés.

- L’intégration de « experts » optimise l’efficacité des réponses en fonction des requêtes.

- Meta utilise environ 350 000 puces Nvidia H100, surpassant ses concurrents.

- Les modèles amélioreront les services Meta, offrant des réponses plus précises et des publicités mieux ciblées.